ESTADÍSTICA APLICADA

A LA

A LA

La

Estadística inferencial: estudia cómo sacar conclusiones

generales para toda la población a partir del estudio de una muestra, y el

grado de fiabilidad o significación de los resultados obtenidos.

PRUEBA

T DE STUDENT

La

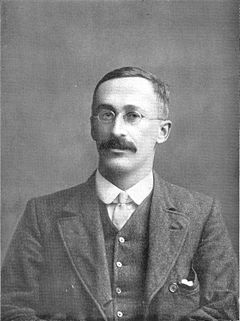

prueba t-Student fue desarrollada en 1899 por el químico inglés William Sealey

Gosset (1876-1937), mientras trabajaba en técnicas de control de calidad para

las destilerías Guiness en Dublín . Debido a que en la destilería, su puesto de

trabajo no era inicialmente de estadístico y su dedicación debía estar exclusivamente

encaminada a mejorar los costes de producción, publicó sus hallazgos

anónimamente firmando sus artículos con el nombre de "Student".

Pruebas de Hipótesis

Una

hipótesis estadística es una suposición hecha con respecto a la función de

distribución de una variable aleatoria.

En

la prueba de una hipótesis estadística, es costumbre declarar la hipótesis como

verdadera si la probabilidad calculada excede el valor tabular llamado el nivel

de significación y se declara falsa si la probabilidad calculada es menor que

el valor tabular.

La

prueba a realizar dependerá del tamaño de las muestras, de la homogeneidad de

las varianzas y de la dependencia o no de las variables.

Si

las muestras a probar involucran a más de 30 observaciones, se aplicará la

prueba de Z, si las muestras a evaluar involucran un número de observaciones

menor o igual que 30 se emplea la prueba de t de student. La fórmula de cálculo

depende de si las varianzas son homogéneas o heterogéneas, si el número de

observaciones es igual o diferente, o si son variables dependientes.

Se

puede describir la prueba t de Student como aquella que se utiliza en un modelo

en el que una variable explicativa (var. independiente) dicotómica intenta

explicar una variable respuesta (var. dependiente) dicotómica. Es decir en la

situación: dicotómica explica dicotómica.

La

prueba t de Student como todos los estadísticos de contraste se basa en el

cálculo de estadísticos descriptivos previos: el número de observaciones, la

media y la desviación típica en cada grupo. A través de estos estadísticos

previos se calcula el estadístico de contraste experimental. Con la ayuda de

unas tablas se obtiene a partir de dicho estadístico el p-valor. Si p<0,05

se concluye que hay diferencia entre los dos tratamientos.

PARA APLICAR LA T DE STUDENT SE DEBE CUMPLIR QUE

- En cada grupo la variable estudiada siga una distribución Normal y que la dispersión en ambos grupos sea homogénea (hipótesis de homocedasticidad=igualdad de varianzas).

- Si no se verifica que se cumplen estas asunciones los resultados de la prueba t de Student no tienen ninguna validez.

TIPOS DE PRUEBA DE

HIPOTESIS

NULA= Ho

Es

aquella que nos dice que no existen diferencias significativas entre los grupos

Una

hipótesis nula es importante por varias razones:

ü Es una hipótesis que se acepta

o se rechaza según el resultado de la investigación.

|

ü El

hecho de contar con una hipótesis nula ayuda a determinar si existe una

diferencia entre los grupos, si esta diferencia es significativa, y si no se

debió al azar.

|

ü No

toda investigación precisa de formular hipótesis nula. Recordemos que la

hipótesis nula es aquella por la cual indicamos que la información a obtener

es contraria a la hipótesis de trabajo.

|

ü Al

formular esta hipótesis, se pretende negar la variable independiente. Es

decir, se enuncia que la causa determinada como origen del problema fluctúa,

por tanto, debe rechazarse como tal.

|

HIPÓTESIS

ALTERNATIVA= Ha

Es cualquier hipótesis que difiera de la

hipótesis nula. Es una afirmación que se acepta si los datos muestrales

proporcionan evidencia suficiente de que la hipótesis nula es falsa. Se le

conoce también como la hipótesis de investigación. El planteamiento de la

hipótesis alternativa nunca contiene un signo de igualdad con respecto al valor

especificado del parámetro.

PRUEBA

T DE STUDENT PARA DATOS RELACIONADOS

Consideraciones

para su uso

El

nivel de medición, en su uso debe ser de intervalo o posterior.

El diseño debe ser relacionado.

Se

deben cumplir las premisas paramétricas

PRUEBA

T PARA MUESTRAS INDEPENDIENTES

El

procedimiento Prueba T para muestras independientes debe utilizarse para comparar las medias de

dos grupos de casos, es decir, cuando la comparación se realice entre las

medias de dos poblaciones independientes

(los individuos de una de las poblaciones son distintos a los individuos de la

otra) como por ejemplo en el caso de la comparación de las poblaciones de

hombres y mujeres. Lo ideal es que para esta prueba los sujetos se asignen

aleatoriamente a dos grupos, de forma que cualquier diferencia en la respuesta

sea debida al tratamiento (o falta de tratamiento) y no a otros factores.

Prueba T

Enunciado

En el L.B Departamento Libertador,

la sección de 3ro A del año escolar 2011-2012 fue sometida a prueba

para determinar el nivel de conocimiento que los estudiantes tenían sobre la célula

animal antes y después de ver un video ilustrativo sobre el tema. Los

resultados se presentan a continuación.

Calificaciones

|

|||||||||||||||

Estudiante

|

1

|

2

|

3

|

4

|

5

|

6

|

7

|

8

|

9

|

10

|

11

|

12

|

13

|

14

|

15

|

Antes de ver el video

|

12

|

15

|

14

|

13

|

17

|

15

|

16

|

18

|

14

|

13

|

12

|

07

|

17

|

16

|

15

|

Luego de ver el video

|

17

|

18

|

14

|

19

|

20

|

17

|

16

|

17

|

19

|

19

|

16

|

10

|

17

|

19

|

20

|

Variable

Dependiente: Calificaciones obtenidas.

Variable

Independiente: El video utilizado.

Tipo

de Prueba T:

Prueba T para muestras relacionadas.

Ho. No

existe diferencia significativa entre las calificaciones obtenidas que presentaron

los estudiantes antes y después de ver el video ilustrativo sobre la célula animal.

Ha. Sí existe diferencia significativa entre las calificaciones obtenidas que presentaron

los estudiantes antes y después de ver el video ilustrativo sobre la célula animal.

Diferencias relacionadas

|

t

|

gl

|

Sig. (bilateral)

|

|||||

Media

|

Desviación típ.

|

Error típ. de la media

|

95% Intervalo de confianza

para la diferencia

|

|||||

Superior

|

Superior

|

|||||||

Par 1

Tradicional - CTS

|

-2,933

|

2,314

|

,597

|

-4,215

|

-4,215

|

-4,911

|

14

|

,000

|

Análisis

P=0,000 0,000<

0,05

α=

0,05 P < α

Se rechaza Ho

Con un 95% de confiabilidad se estima que Sí existe diferencia significativa entre las calificaciones obtenidas que presentaron

los estudiantes de 3ro A del L.B Departamento Libertador,

la sección 2011-2012 antes y después de ver el video ilustrativo sobre la célula animal.

Chi-cuadrado

El método que se sigue es el siguiente:

1)

Se designan las frecuencias observadas con letras minúsculas y con letras

mayúsculas las frecuencias esperadas o teóricas.

2)

Las frecuencias se presentan en cuadros o tablas con un cierto número de

columnas y de filas.

PRUEBAS NO PARAMÉTRICAS:

Se

denominan pruebas no paramétricas aquellas que no presuponen una distribución

de probabilidad para los datos, por ello se conocen también como de

distribución libre (distribution free). En la mayor parte de ellas los

resultados estadísticos se derivan únicamente a partir de procedimientos de

ordenación y recuento, por lo que su base lógica es de fácil comprensión

PRUEBA DE BONDAD DE

AJUSTE, consiste en determinar si

los datos de cierta muestra corresponden a cierta distribución poblacional. En

este caso es necesario que los valores de la variable en la muestra y sobre la

cual queremos realizar la inferencia esté dividida en clases de ocurrencia, o

equivalentemente, sea cual sea la variable de estudio, deberemos categorizar

los datos asignado sus valores a diferentes clases o grupos

chi – cuadrado para una

muestra se utiliza cuando:

Ø Cuando

los datos puntualizan a las variables cualitativa (nominal u ordinal).

Ø Poblaciones

pequeñas.

Ø Cuando

se desconocen los parámetros media, moda,

Ø Cuando

se quiere contrastar o comparar hipótesis.

Ø Investigaciones

de tipo social - muestras pequeñas no representativas

>5.

Ø Población

> a 5 y < a 20

Su

función es comparar dos o más de dos distribuciones de proporciones y

determinar que la diferencia no se deba al azar (que las diferencia sea estadísticamente

significativa)

La prueba de X2 se aplica en situaciones como estas:

a) Probar la bondad de

ajuste de la distribución de una variable en la naturaleza a una distribución

teórica.

b) Probar la

independencia entre variables cualitativas.

Requisitos para poder aplicar la prueba de X2:

1. Trabajar con

frecuencias. Si se trabaja con porcentajes hay que aplicar una corrección, para

transformarlas en frecuencias absolutas.

2. Las clases deben ser

mutuamente excluyentes, es decir, un individuo u observación debe caer

solamente dentro de una de ellas.

2. Las clases deben ser

mutuamente excluyentes, es decir, un individuo u observación debe caer

solamente dentro de una de ellas.

3. Las clases deben ser

exhaustivas, es decir, todos los individuos deben quedar incluidos en algunas

de las clases.

4. Las variables deben

ser discretas y cualitativas (Escalas Nominal y Ordinal).

5. Las sumas entre las

frecuencias absolutas y observadas y las frecuencias absolutas esperadas

(calculadas) deben ser igual a cero.

6.

Se deben considerar también el tamaño de la muestra (n), pues a medida que esta

disminuye, la eficiencia de X2 , como una medida de ajuste entre distribuciones

de frecuencias, también disminuye. Se sugiere un valor mínimo de n ≤ 50.

7. Debe evitarse la

presencia de frecuencias absolutas calculadas muy pequeñas en las casillas

individuales. Si la frecuencia teórica es < que 1 la prueba Chi cuadrado no puede

ser usada.

Enunciado

En un estudio realizado a 75 familias de

Barquisimeto en el año 2012. Se consideraron las variables “Nivel de

conocimiento sobre los métodos anticonceptivos” y el “Número de hijos” los resultados obtenidos se ubican en la

siguiente tabla:

Nivel de conocimiento

|

Número de

hijos

|

|||

1-3 hijos

|

3-5 hijos

|

Más de 6 hijos

|

Total

|

|

Poco

|

8

|

9

|

10

|

27

|

Mediano

|

13

|

7

|

8

|

28

|

Mucho

|

14

|

4

|

2

|

20

|

Total

|

35

|

18

|

22

|

75

|

Variable

Independiente: Nivel de conocimiento sobre los métodos

anticonceptivos.

Variable

Dependiente: Número

de hijos.

Tipo

de análisis:

Chi cuadrado, “Tabla de contingencia”

Ho. No

existe asociación entre el nivel de conocimiento de la madre sobre los métodos

anticonceptivos y el número de hijos de las familias de Barquisimeto encuestadas

en el año 2012.

Ha. Sí

existe asociación entre el nivel de conocimiento de la madre sobre los métodos

anticonceptivos y el número de hijos de las familias de Barquisimeto

encuestadas en el año 2012.

Tabla

de contingencia nivel * hijos

Recuento

hijos

|

Total

|

||||

1-3hijos

|

3-5hijos

|

>6hijos

|

1-3hijos

|

||

nivel

|

Poco

|

27

|

0

|

0

|

27

|

Mediano

|

8

|

18

|

2

|

28

|

|

Mucho

|

0

|

0

|

20

|

20

|

|

Total

|

35

|

18

|

22

|

75

|

|

Pruebas de chi-cuadrado

Valor

|

gl

|

Sig. asintótica (bilateral)

|

|

Chi-cuadrado de Pearson

|

104,638(a)

|

4

|

,000

|

Razón de verosimilitudes

|

112,183

|

4

|

,000

|

Asociación lineal por lineal

|

61,141

|

1

|

,000

|

N de casos válidos

|

75

|

a 1 casillas

(11,1%) tienen una frecuencia esperada inferior a 5. La frecuencia mínima

esperada es 4,80.

Análisis

P=0,000 0,000

< 0,05

α=

0,05 P < α

Se rechaza Ho

Con un 95% de confiabilidad se estima que Sí

existe asociación entre el nivel de conocimiento de la madre sobre los métodos

anticonceptivos y el número de hijos de las familias de Barquisimeto

encuestadas en el año 2012.

ANÁLISIS DE VARIANZA (ANOVA)

Las técnicas iníciales del análisis de varianza fueron

desarrolladas por el estadístico y genetista R. A. Fisher en

los años 1920 y 1930 y es algunas veces conocido como "Anova de Fisher"

o "análisis de varianza de Fisher", debido al uso de la distribución

F de Fisher como parte del contraste de hipótesis.

Existen tres clases conceptuales de estos modelos:

- El Modelo de efectos fijos asume que los datos provienen de poblaciones normales las cuales podrían diferir únicamente en sus medias.

- El Modelo de efectos aleatorios asume que los datos describen una jerarquía de diferentes poblaciones cuyas diferencias quedan restringidas por la jerarquía. Ejemplo: El experimentador ha aprendido y ha considerado en el experimento sólo tres de muchos más métodos posibles, el método de enseñanza es un factor aleatorio en el experimento.

- El Modelo de efectos mixtos describen situaciones que éste puede tomar. Ejemplo: Si el método de enseñanza es analizado como un factor que puede influir donde están presentes ambos tipos de factores: fijos y aleatorios.

Supuestos Previos

El

ANOVA parte de algunos supuestos que han de cumplirse:

Ø La

variable dependiente debe medirse al menos a nivel de intervalo.

Ø Independencia de las observaciones.

Ø La

distribución de los residuales debe ser normal.

Ø Homocedasticidad: homogeneidad de las

varianzas.

La

técnica fundamental consiste en la separación de la suma de cuadrados (SS, 'sum

of squares') en componentes relativos a los factores contemplados en el modelo.

Como ejemplo, mostramos el modelo para un ANOVA simplificado con un tipo de

factores en diferentes niveles. (Si los niveles son cuantitativos y los efectos

son lineales, puede resultar apropiado un análisis de regresión lineal)

El

número de grados de libertad (gl) puede separarse de forma similar y

corresponde con la forma en que la distribución chi-cuadrado(χ² o Ji-cuadrada)

describe la suma de cuadrados asociada.

ANÁLISIS DE LA VARIANZA (ANOVA)

ANOVA son siglas para el análisis de la Variación (ANalysis Of VAriance).

ANOVA son siglas para el análisis de la Variación (ANalysis Of VAriance).

Un ANOVA segrega

diversas fuentes de la variación vistas en resultados experimentales.

Conjunto de técnicas

estadísticas para conocer el modo en que el valor medio de una variable es

afectado por diferentes tipos de clasificaciones de los datos.

Con el análisis de la

varianza se pueden ajustar las estimaciones del efecto de un tratamiento según

otros factores como sexo, edad, gravedad, etc.

Es una técnica

estadística que sirve para decidir/determinar si las diferencias que existen

entre las medias de tres o más grupos (niveles de clasificación) son

estadísticamente significativas.

Las técnicas de ANOVA

se basan en la partición de la varianza para establecer si la varianza

explicada por los grupos formados es suficientemente mayor que la varianza

residual o no explicada.

El análisis de la

varianza (ANOVA) es una técnica estadística de contraste de hipótesis.

Tradicionalmente estas

técnicas, conjuntamente con las técnicas de regresión lineal múltiple, de las

que prácticamente son una extensión natural, marcan el comienzo de las técnicas

multivariantes.

Con estas técnicas se

manejan simultáneamente más de dos variables, y la complejidad del aparato

matemático se incrementa proporcionalmente con el número de variables en juego.

El análisis de la

varianza de un factor es el modelo más simple: una única variable nominal

independiente, con tres o más niveles, explica una variable dependiente

continua.

Otra alternativa, que

aparentemente es más lógica e intuitiva, consiste en comparar, en todas las

posibles combinaciones de dos en dos, las medias de todos los subgrupos

formados.

En el ANOVA se comparan

medias, no varianzas: medias de los subgrupos o estratos originados por los

factores de clasificación estudiados.

Un ANOVA entonces

prueba si la variación asociada a una fuente explicada es grande concerniente a

la variación inexplicada.

Si ese cociente (la

estadística de F) es tan grande que la probabilidad que ocurrió por casualidad

es baja (por ejemplo, P<=0.05), podemos concluir (en ese nivel de la

probabilidad) que esa fuente de la variación tenía un efecto significativo

CONDICIONES GENERALES DE APLICACIÓN.

A- INDEPENDENCIA DE LOS

ERRORES I

Los errores

experimentales han de ser independientes Se consigue si los sujetos son

asignados aleatoriamente. Es decir, se consigue esta condición si los elementos

de los diversos grupos han sido elegidos por muestreo aleatorio

B- NORMALIDAD

Se supone que los

errores experimentales se distribuyen normalmente. Lo que supone que cada una

de las puntuaciones yi.i se distribuirá normalmente.

Para comprobarlo se

puede aplicar un test de ajuste a la distribución normal como et de

Kolmogov-Smirnov.

C- HOMOGENEIDAD DE VARIANZAS (HOMOSCEDASTICIDAD).

La varianza de los

subgrupos ha de ser homogénea σ21 = σ22 = .....= σ2k ya que están debidas al

error. Se comprobarán mediante los test de: Razón de varianzas (máx. /min), C

de Cochran, Barlett-Box…

ANÁLISIS DE LA COVARIANZA (ANCOVA)

.jpg)

Método de análisis estadístico que es una extensión del análisis de la varianza, que permite ajustar los estimadores del efecto de un tratamiento según posibles covariables y factores.

Es una técnica

estadística que combina ANOVA (pues compara medias entre grupos) y análisis de

regresión (ajusta las comparaciones de las medias entres los grupos por

variables continuas o covariables)

Análisis de Varianza (ANOVA)

El análisis de varianza, como técnica de lo que trata es: si se está

estudiando la característica cuyos valores dependen de varias clases de efectos

que operan simultáneamente, poder decidir si tales efectos son debido al azar o

si realmente son diferentes.

·

¿Cómo funciona el análisis de varianza, en el modelo de clasificación simple?

Esta técnica de lo que trata es de expresar una medida de la variación total de

un conjunto de datos como una suma de términos, que se pueden atribuir a

fuentes o causas específicas de variación; pues bien esta descomposición de la

varianza total se denomina: Identidad fundamental. Ella junto a la formación

del estadístico de prueba, se refleja en una tabla llamada “ Tabla de Análisis

de Varianza”, que resume los principales aspectos teóricos prácticos de la

técnica.

·

2 .s 2 se tiene que: Por lo tanto si todas las medias son iguales entonces: ,

mientras que si alguna es diferente, se puede concluir que De modo que una

comparación de varianza puede conducir a una conclusión sobre la igualdad de

medias poblacionales. El método que se utiliza es a través de los estimadores

de s4. ¿Cómo podemos comparar medias y tomar decisiones a través de la

varianza? Hay un corolario que plantea que: Si “k” poblaciones se unen y las

varianzas de las “k” poblaciones son iguales a

·

El análisis de varianza consiste en dividir la suma de cuadrado total en dos

fuentes de variación y proceder al análisis de las mismas, estas son la

variación dentro del grupo y la variación entre grupos. Como son variaciones la

vamos a expresar como sumas de cuadrados, es decir: SC T = SC D + SC E __ __ __

__ (Y ij - Y) = (Y ij - Y i ) + (Y i – Y)

Enunciado

.jpg) Se desea evaluar la eficacia (en escala del 1 al 4)de un determinado

fármaco para reducir los niveles de ansiedad en pacientes diagnosticados con

dicho trastorno. Para ello, se considera la asesoría médica que señala tanto los

niveles, como los síntomas que determinan la ansiedad; estos son,Niveles:

1=Bajo nivel de ansiedad, 2=Nivel de ansiedad normal,

3=Nivel de ansiedad elevado, 4=Nivel de ansiedad muy alto y los Síntomas:

dilatación de la pupila, sudoración, molestias estomacales, aceleración cardiaca

y la piloerección. Ahora bien, para realizar la prueba se selecciona al azar un

grupo de 100 pacientes que sufren este problema y se forman aleatoriamente

cuatro grupos del mismo tamaño, esto con el fin de responder a ¿Cuál esla

eficacia del fármaco para reducir el nivel de ansiedad? Es por ello

que a cada grupo se le administra una dosis distinta del fármaco (5, 10, 20 y

30 miligramos respectivamente), al cabo de un tiempo, se lepregunta a cada

paciente cuál es la escala conque miden el nivel de ansiedad y los resultados

son los siguientes:

Se desea evaluar la eficacia (en escala del 1 al 4)de un determinado

fármaco para reducir los niveles de ansiedad en pacientes diagnosticados con

dicho trastorno. Para ello, se considera la asesoría médica que señala tanto los

niveles, como los síntomas que determinan la ansiedad; estos son,Niveles:

1=Bajo nivel de ansiedad, 2=Nivel de ansiedad normal,

3=Nivel de ansiedad elevado, 4=Nivel de ansiedad muy alto y los Síntomas:

dilatación de la pupila, sudoración, molestias estomacales, aceleración cardiaca

y la piloerección. Ahora bien, para realizar la prueba se selecciona al azar un

grupo de 100 pacientes que sufren este problema y se forman aleatoriamente

cuatro grupos del mismo tamaño, esto con el fin de responder a ¿Cuál esla

eficacia del fármaco para reducir el nivel de ansiedad? Es por ello

que a cada grupo se le administra una dosis distinta del fármaco (5, 10, 20 y

30 miligramos respectivamente), al cabo de un tiempo, se lepregunta a cada

paciente cuál es la escala conque miden el nivel de ansiedad y los resultados

son los siguientes:

5 mg.

|

10 mg.

|

20 mg.

|

30 mg.

|

4

|

2

|

2

|

2

|

3

|

3

|

2

|

2

|

2

|

4

|

1

|

1

|

3

|

4

|

3

|

2

|

4

|

3

|

1

|

1

|

4

|

3

|

2

|

4

|

2

|

3

|

4

|

3

|

4

|

1

|

2

|

2

|

3

|

2

|

3

|

1

|

2

|

3

|

2

|

1

|

4

|

4

|

1

|

2

|

2

|

3

|

2

|

3

|

3

|

2

|

2

|

2

|

3

|

4

|

2

|

1

|

4

|

3

|

3

|

2

|

3

|

2

|

1

|

2

|

3

|

4

|

2

|

1

|

4

|

3

|

1

|

2

|

4

|

2

|

2

|

2

|

3

|

3

|

2

|

1

|

2

|

2

|

2

|

1

|

3

|

4

|

3

|

3

|

4

|

4

|

2

|

2

|

3

|

3

|

2

|

1

|

4

|

4

|

1

|

2

|

Solución

Variable Dependiente: Nivel de

Ansiedad

Variable Independiente: Dosis del Fármaco

Hipótesis Nula (Ho):La eficacia del fármaco para reducir el nivel de

ansiedad en lospacientes que la padecen,es igual para cuando se administra en

dosis diferentes.

Hipótesis Alternativa (Ha): La eficacia del fármaco para reducir

los niveles de ansiedad en los pacientes que la padecen, depende

significativamente de cuando se administran dosis diferentes del tratamiento.

Tipo de Prueba a Aplicar: ANOVA de un factor.

Descriptivos

|

||||||||

Ansiedad

|

||||||||

N

|

Media

|

Desviación típica

|

Error típico

|

Intervalo de confianza para la media al 95%

|

Mínimo

|

Máximo

|

||

Límite inferior

|

Límite superior

|

|||||||

5 miligramos

|

25

|

3,20

|

,764

|

,153

|

2,88

|

3,52

|

2

|

4

|

10 miligramos

|

25

|

3,00

|

,866

|

,173

|

2,64

|

3,36

|

1

|

4

|

20 miligramos

|

25

|

2,00

|

,764

|

,153

|

1,68

|

2,32

|

1

|

4

|

30 miligramos

|

25

|

1,84

|

,800

|

,160

|

1,51

|

2,17

|

1

|

4

|

Total

|

100

|

2,51

|

,990

|

,099

|

2,31

|

2,71

|

1

|

4

|

Prueba de homogeneidad de varianzas

|

|||

Ansiedad

|

|||

Estadístico de Levene

|

gl1

|

gl2

|

Sig.

|

,533

|

3

|

96

|

,661

|

ANOVA de un factor

|

|||||

Ansiedad

|

|||||

Suma de cuadrados

|

gl

|

Media cuadrática

|

F

|

Sig.

|

|

Inter-grupos

|

35,630

|

3

|

11,877

|

18,581

|

,000

|

Intra-grupos

|

61,360

|

96

|

,639

|

||

Total

|

96,990

|

99

|

|||

Pruebas post hoc

Comparaciones múltiples

Variable dependiente: Ansiedad

HSD de Tukey

|

|||||||

(I) Dosis

|

(J) Dosis

|

Diferencia de medias (I-J)

|

Error típico

|

Sig.

|

Intervalo de confianza al 95%

|

||

Límite inferior

|

Límite superior

|

||||||

5 miligramos

|

10 miligramos

|

,200

|

,226

|

,813

|

-,39

|

,79

|

|

20 miligramos

|

1,200*

|

,226

|

,000

|

,61

|

1,79

|

||

30 miligramos

|

1,360*

|

,226

|

,000

|

,77

|

1,95

|

||

10 miligramos

|

5 miligramos

|

-,200

|

,226

|

,813

|

-,79

|

,39

|

|

20 miligramos

|

1,000*

|

,226

|

,000

|

,41

|

1,59

|

||

30 miligramos

|

1,160*

|

,226

|

,000

|

,57

|

1,75

|

||

20 miligramos

|

5 miligramos

|

-1,200*

|

,226

|

,000

|

-1,79

|

-,61

|

|

10 miligramos

|

-1,000*

|

,226

|

,000

|

-1,59

|

-,41

|

||

30 miligramos

|

,160

|

,226

|

,894

|

-,43

|

,75

|

||

30 miligramos

|

5 miligramos

|

-1,360*

|

,226

|

,000

|

-1,95

|

-,77

|

|

10 miligramos

|

-1,160*

|

,226

|

,000

|

-1,75

|

-,57

|

||

20 miligramos

|

-,160

|

,226

|

,894

|

-,75

|

,43

|

||

*. La diferencia de medias

es significativa al nivel 0.05.

Subconjuntos

homogéneos

Ansiedad

|

|||

HSD de Tukey

|

|||

Dosis

|

N

|

Subconjunto para alfa = 0.05

|

|

1

|

2

|

||

30 miligramos

|

25

|

1,84

|

|

20 miligramos

|

25

|

2,00

|

|

10 miligramos

|

25

|

3,00

|

|

5 miligramos

|

25

|

3,20

|

|

Sig.

|

,894

|

,813

|

|

Se muestran las medias para los

grupos en los subconjuntos homogéneos.

|

|||

a. Usa el tamaño muestral de la media

armónica = 25,000.

|

|||

Cálculos:

Levenne Sig. = 0,661>α = 0,05

Las varianzas son Homogéneas

No Rechazo Ho para Homogeneidad

ANOVA: P = 0,000<α = 0,05 por lo que: Se Rechaza Ho

Conclusión: Se

puede considerar bajo un nivel de confianza del 95% que la eficacia

del fármaco para reducir el nivel de ansiedad en los pacientes que la padecen,

depende significativamente de cuando se administran dosis diferentes del

tratamiento; es decir, hay suficiente evidencia estadística para concluir que

existe diferencia significativa entre las dosis del fármaco para reducir los

niveles de ansiedad. En este caso, para verificar entre cuáles

dosis está la diferencia, se aplicó la prueba de Tukey por tratarse de grupos

que poseen el mismo tamaño muestral, donde se obtuvo que las dosis 30 miligramos

y 20 miligramos marcan la diferencia significativa, en este caso son las dosis

para que el tratamiento sea más efectivo.

Nota: El

contraste no paramétrico de Kruskal-Wallis es el equivalente a un análisis de

varianza de una sola vía, el cual se aplica generalmente para determinar si

varias muestras independientes proceden de la misma población.

REGRESIÓN

CORRELACIÓN

.jpg) En

múltiples ocasiones en la práctica cotidiana nos encontramos con situaciones en

las que se requiere analizar la relación entre dos variables cuantitativas. Los

dos objetivos fundamentales de este análisis serán, por un lado, determinar si

dichas variables están asociadas y en qué sentido se da dicha asociación (es

decir, si los valores de una de las variables tienden a aumentar o disminuir,

al aumentar los valores de la otra); y por otro, estudiar si los valores de una

variable pueden ser utilizados para predecir el valor de la otra.

En

múltiples ocasiones en la práctica cotidiana nos encontramos con situaciones en

las que se requiere analizar la relación entre dos variables cuantitativas. Los

dos objetivos fundamentales de este análisis serán, por un lado, determinar si

dichas variables están asociadas y en qué sentido se da dicha asociación (es

decir, si los valores de una de las variables tienden a aumentar o disminuir,

al aumentar los valores de la otra); y por otro, estudiar si los valores de una

variable pueden ser utilizados para predecir el valor de la otra.

La

forma correcta de abordar el primer problema es recurriendo a coeficientes de

correlación. Sin embargo, el estudio de la correlación es insuficiente para

obtener una respuesta al segundo punto: se limita a indicar la fuerza de la

asociación mediante un único número, tratando las variables de modo simétrico,

mientras que nosotros estaríamos interesados en moldear dicha relación y usar

una de las variables para explicar la otra. Para tal propósito se recurrirá a la

técnica de regresión y correlación, donde se analizará el caso más sencillo en

el que se considera únicamente la relación entre dos variables.

La

Regresión y la correlación son dos técnicas estadísticas que se pueden utilizar

para solucionar problemas comunes en los negocios.Muchos estudios se basan en

la creencia de que es posible identificar y cuantificar alguna Relación

Funcional entre dos o más variables, donde una variable depende de la otra

variable.

Se

puede decir que Y depende de X, en donde Y y X son dos variables cualquiera en

un modelo de Regresión Simple.

"Y es una función de X"

Y = f(X)

Como

Y depende de X,

Y

es la variable dependiente, y

X

es la variable independiente.

En

el Modelo de Regresión es muy importante identificar cuál es la variable

dependiente y cuál es la variable independiente. Es por ello, que de acuerdo a

lo señalado porRábago y Otros (2007) que el estudio de la Regresión Lineal

permite calcular los coeficientes de la ecuación lineal de una o más variables

independientes que mejor predicen el valor de la variable dependiente. La

regresión lineal, por lo tanto, consiste en obtener una función lineal de las

variables independientes que permita explicar o predecir el valor de la

dependiente. En el caso de considerar una sola variable independiente, se

denomina Regresión Lineal Simple, si se trata de más de una variable

independiente, se utiliza el modela de Regresión Múltiple.

Esto

conduce al estudio de la regresión y la Correlación de las variables; pues la

correlación se utiliza para establecer la fuerza de asociación entre las dos

variables, de allí que esta asociación se exprese con un valor numérico

comprendido entre 0,000 cuando no existe correlación y 1.00 cuando la

correlación es perfecta.

Ahora

bien, la escala adaptada por la mayoría de los autores para valorar la magnitud

de la correlación es la siguiente:

Valor de Referencia

|

Correlación

|

De 0,00 a 0,20

|

Muy baja

|

De 0,21 a 0,40

|

Baja

|

De 0,41 a 0,60

|

Moderada

|

De 0,61 a 0,80

|

Alta

|

De 0,81 a 1,00

|

Muy Alta

|

Fuente: Ruiz (2002)

El

análisis de correlación produce un número que resume el grado de correlación

entre dos variables; y el análisis de regresión origina una ecuación matemática

que describe dicha relación, determina la naturaleza de la relación (lineal,

logarítmica, exponencial, entre otras) y permite hacer predicciones.

Bajo

este mismo enfoque, Rábago y Otros

(ob.cit.) resaltan que la regresión y la correlación son dos técnicas que

involucran una forma de estimación que están estrechamente relacionadas entre

sí. La ecuación matemática de regresión, describe la relación de las variables

mediante una “recta ajustada” equidistante entre los puntos del diagrama de

dispersión de las dos variables en estudio. Esta ecuación se puede utilizar

para estimar o predecir los valores futuros que puede tener una variable cuando

se conocen o suponen los valores de la otra.

En

este sentido, en el Modelo de Regresión Simple se establece que Y es una

función de sólo una variable independiente, razón por la cual se le denomina

también Regresión Divariada porque sólo hay dos variables, una dependiente y

otra independiente y se representa así:

Y

= f (X)

"Y

está regresando por X"

La

variable dependiente es la variable que se desea explicar, predecir. También se

le llama REGRESANDO o VARIABLE DE RESPUESTA.

La

variable Independiente X se le denomina VARIABLE EXPLICATIVA ó REGRESOR y se le

utiliza para EXPLICAR Y.

Uno

de los aspectos más relevantes de la Estadística es el análisis de la relacióno

dependencia entre variables. Frecuentemente resulta de interés conocer elefecto

que una o varias variables pueden causar sobre otra, e incluso predeciren mayor

o menor grado valores en una variable a partir de otra. Por ejemplo,supóngase

que la altura de los padres influye significativamente en la de loshijos. Se

podría estar interesado en estimar la altura media de los hijos cuyospadres

presentan una determinada estatura.Los métodos de regresión estudian la

construcción de modelos para explicaro representar la dependencia entre una

variable respuesta o dependiente (Y) yla(s) variable(s) explicativa(s) o

dependiente(s), X. En este Tema se abordaran contenidos para explicarel modelo

de regresión lineal, que tiene lugar cuando la dependencia es de tipolineal, y

se dará respuesta a dos cuestiones básicas:

¿Es

significativo el efecto que una variable X causa sobre otra Y? ¿Essignificativa

la dependencia lineal entre esas dos variables? y; de ser así, se utilizará el modelo de regresión lineal simple para

explicary predecir la variable dependiente (Y) a partir de valores observados

enla independiente (X).

ANÁLISIS ESTADÍSTICO: REGRESIÓN LINEALSIMPLE

.jpg) En el estudio de

la relación funcional entre dos variables poblacionales, una variable X,

llamada independiente, explicativa o de predicción y una variable Y, llamada

dependiente o variable respuesta, presenta la siguiente notación:

En el estudio de

la relación funcional entre dos variables poblacionales, una variable X,

llamada independiente, explicativa o de predicción y una variable Y, llamada

dependiente o variable respuesta, presenta la siguiente notación:

Y

= a + b X + e

Donde:

a=

es el valor de la ordenada donde la línea de regresión se intercepta con el eje

Y

b=

es el coeficiente de regresión poblacional (pendiente de la línea recta)

e=

es el error

SUPOSICIONES

DE LA REGRESIÓN LINEAL

1. Los valores de la variable independiente X son fijos, medidos sin error.

2. La variable Y es aleatoria

3. Para cada valor de X, existe una distribución normal de

valores de Y (subpoblaciones Y)

4. Las variancias de las subpoblaciones Y son todas iguales.

5. Todas las medias de las subpoblaciones de Y están sobre la recta.

6. Los valores de Y están normalmente distribuidos y son estadísticamente

independientes.

El modelo de regresión lineal. La estructura del modelo de regresión lineal es la

siguiente:Y = β0 + β1X + ε

En

esta expresión se está admitiendo que todos los factores o causas queinfluyen

en la variable respuesta Y pueden dividirse en dos grupos: el primerocontiene a

una variable explicativa X y el segundo incluye un conjunto amplio defactores

no controlados que se engloban bajo el nombre de perturbación o erroraleatorio,

ε, que provoca que la dependencia entre las variables dependiente

eindependiente no sea perfecta, sino que esté sujeta a incertidumbre. Por

ejemplo,en el consumo de gasolina de un vehículo (Y ) influyen la velocidad (X)

y unaserie de factores como el efecto conductor, el tipo de carretera, las

condicionesambientales, entre otros, que quedarían englobados en el error.

Lo

que en primer lugar sería deseable en un modelo de regresión es queestos

errores aleatorios sean en media cero para cualquier valor x de X, es decir,

E[ε/X

= x] = E[ε] = 0, y por lo tanto:

E[Y

/X = x] = β0 + β1x + E[ε/X = x] = β0 + β1x

En

dicha expresión se observa que:

•

La media de Y, para un valor fijo x, varía linealmente con x.

•

Para un valor x se predice un valor en Y dado por ˆy = E[Y /X = x] =β0 + β1x,

por lo que el modelo de predicción puede expresarse tambiéncomoˆY = β0 + β1X.

•

El parámetro β0 es la ordenada al origen del modelo (punto de corte conel eje

Y) y β1 la pendiente, que puede interpretarse como el incremento dela variable

dependiente por cada incremento en una unidad de la variableindependiente.

Estos parámetros son desconocidos y habrá que estimarlosde cara a realizar

predicciones.

Además

de la hipótesis establecida sobre los errores de que en media han deser cero,

se establecen las siguientes hipótesis:

i) La varianza de ε es constante para cualquier valor de x, es decir,V

ar(ε/X = x) = σ2

ii) iii) La distribución de ε es normal, de media 0 y desviación σ.

iii) iv) Los errores asociados a los valores de Y son independientes unos de

otros.

En

consecuencia, la distribución de Y para x fijo es normal, con varianzaconstante

σ2, y media que varía linealmente con x, dada por β0 +β1x. Ademáslos valores de

Y son independientes entre sí.

Una

vez observado que en una variable bidimensional existe una cierta dependencia

entre las dos características o variables que la forman, lo cual se observa en

la nube de puntos del diagrama de dispersión, se puede precisar el grado de

dicha dependencia. En otras palabras, si los puntos de la nube se presentan

todos sobre la recta de regresión se dice que existe una dependencia funcional

perfecta; por el contrario, si los puntos no están todos sobre la recta (pero

sí con una tendencia a la linealidad) se dice que entre las variables hay una

cierta correlación lineal y se procede a calcular el Coeficiente de

Correlación.

Este

coeficiente informa del grado de relación entre dos variables. Si la relación

es lineal perfecta, r será 1 ó -1. El coeficiente r será positivo si la relación es positiva (al aumentarx aumenta y), y r será negativo en el caso

contrario (si al aumentar x, disminuye y).En general, valores (absolutos) de r> 0,80 se consideran altos, aunque esto depende delnúmero de parejas

de datos con las que se haya realizado el cálculo y del nivel de seguridadcon

el que se quiera extraer las conclusiones.

Correlación de Pearson

Ho: r = 0 (no existe relación)

Ha: r = 0 (existe relación)

Para

el estudio del coeficiente de correlación Pearson se hace necesario tomar en

cuenta algunas características de este estadístico, tal y como se señala en el

procesamiento estadístico de datos con SPSS de Rábago y Otros (ob.cit.):

a)El

valor del coeficiente de correlación es muy sensible a la presencia de un valor

extremo, como sucede con la desviación típica. En estos casos se recomienda

realizar una transformación de datos que cambia la escala de medición y modera

el efecto de valores extremas, como es el caso de la transformación

logarítmica.

b) El coeficiente de correlación mide sólo la relación con una línea recta.

Dos variables pueden tener una relación curvilínea fuerte, a pesar de que su

correlación sea pequeña. Por tanto cuando se analicen las relaciones entre dos

variables, primero se deben representar en forma gráfica y posteriormente

calcular el coeficiente de correlación.

c)El

coeficiente de correlación no se debe extrapolar más allá del rango de valores

observado de las variables a estudio, puesto que la relación existente entre X

y Y puede cambiar fuera de dicho rango.

.jpg) d) La correlación no implica necesariamente causalidad. La causalidad es un

juicio de valor que requiere más información que un simple valor cuantitativo

de un coeficiente de correlación.

d) La correlación no implica necesariamente causalidad. La causalidad es un

juicio de valor que requiere más información que un simple valor cuantitativo

de un coeficiente de correlación.

e)Un

coeficiente de correlación con valor reducido no indica necesariamente que no

exista correlación, dado que las variables pueden presentar una relación no

lineal.

f) La estimación de coeficiente de determinación (r2) muestra el

porcentaje de la variabilidad de los datos que se explica por la asociación

entre las dos variables.

Dentro

de este apartado, señalan los autores antes citados que para que la prueba de

hipótesis sobre la correlación entre las variables sea válida, se requiere que

los datos cumplan ciertas condiciones como:

1. Las dos variables deben proceder de una muestra aleatoria de individuos.

2. Al menos una de las variables debe tener una distribución normal en la

población de la cual procede la muestra. Si los datos no tienen una

distribución normal, una o más variables se pueden transformar (transformación

logarítmica).

3. Cuando las variables no tienen distribución normal o los datos están en

escala ordinal, se calcula el coeficiente de correlación No paramétrico de Spearman que tiene el

mismo significado que el coeficiente de Correlación de

Pearson y se calcula utilizando el rango

de las observaciones.

No

hace falta entrar en el estudio del nivel de significación del coeficiente r, pero como indicación:para 11 parejas de datos, y si se admite un 5% de

posibilidades de equivocación, con r>0,553 ya se

puede decir que ambas series de datos no son independientes (parece que tienen

algún tipo derelación). Si se tuvieran 50 parejas de datos, bastaría r>0,273 para sacar la misma conclusión(siempre considerando el valor

absoluto de r)

Si

se desea ser más estricto y sacar la conclusión de que las dos series no son

independientes con un 99% de seguridad (sólo un 1% de posibilidad de error),

con 11 parejasnecesitamos que r>0,684 y con

50 parejas r>0,354

Precauciones:

1.

El estar seguros de que ambas series están relacionadas, no quiere decir que la

relación sea tan estrecha como para estimar valores de y desconocidos a partir

de valores de xconocidos; eso dependerá del error de estimación que se acepte.

2.

La existencia de una correlación no indica relación causa-efecto.

Para

mayor información y conocer ejemplos donde se puede aplicar este coeficiente

visita: http://hidrologia.usal.es/practicas/correlacion/Correlacion_explicacion.pdf

Enunciado:

Enunciado:

Se lleva a cabo un estudio en

la Urb. Antonio José de Sucre, Sector los Próceres Guanare - Estado Portuguesa en el mes de Noviembre de

2011con relación al peso (Kg) de 10 Padres y del mayor de sus hijos Varones, luego

de realizar durante una semana una serie de ejercicios Físicos, los datos

fueron los siguientes:

|

X

Padres (Kg)

|

98

|

88

|

100

|

125

|

90

|

93

|

101

|

73

|

132

|

77

|

|

Y Hijos

Varones (Kg)

|

62

|

55

|

45

|

89

|

65

|

45

|

35

|

54

|

95

|

63

|

Variable dependiente: Peso (Kg) de los Hijos Varones

Mayor

Variable Independiente: Peso (Kg) de los Padres

Ho= No

existe correlación entre el peso del los padres y el peso de los hijos después

de una semana de ejercicios Físicos.

Ha=

Existe correlación entre el peso del los padres y el peso de los hijos después

de una semana de ejercicios Físicos.

Conclusión:

Correlación de Pearson Sig=0,046 <α= 0, 05, por lo que

se rechaza Ho.

Con un 95% de confiabilidad se determina que existe

correlación entre el peso de los padres el peso de los hijos después de una

semana de ejercicios Físicos. Donde la correlación de Pearson = 0,929 siendo

perfecta positiva y muy alta.

|

Variables

Entered/Removeda

|

|||

|

Model

|

Variables

Entered

|

Variables

Removed

|

Method

|

|

1

|

Padresb

|

.

|

Enter

|

|

a. Dependent Variable: Hijos

|

|||

|

b. All requested variables entered.

|

|||

|

Model

Summary

|

||||

|

Model

|

R

|

R Square

|

Adjusted

R Square

|

Std.

Error of the Estimate

|

|

1

|

,640a

|

,409

|

,335

|

15,452

|

|

a. Predictors: (Constant), Padres

|

||||

|

ANOVAa

|

||||||

|

Model

|

Sum of

Squares

|

df

|

Mean

Square

|

F

|

Sig.

|

|

|

1

|

Regression

|

1323,371

|

1

|

1323,371

|

5,542

|

,046b

|

|

Residual

|

1910,229

|

8

|

238,779

|

|

|

|

|

Total

|

3233,600

|

9

|

|

|

|

|

|

a. Dependent Variable: Hijos

|

||||||

|

b. Predictors: (Constant), Padres

|

||||||

|

Coefficientsa

|

||||||

|

Model

|

Unstandardized

Coefficients

|

Standardized

Coefficients

|

t

|

Sig.

|

||

|

B

|

Std.

Error

|

Beta

|

||||

|

1

|

(Constant)

|

-2,505

|

27,330

|

|

-,092

|

,929

|

|

Padres

|

,648

|

,275

|

,640

|

2,354

|

,046

|

|

|

a. Dependent Variable: Hijos

|

||||||

Referencias

Cinemática. (sf) Regresión lineal.

(Documento en línea). Disponible: http://www.sc.ehu.es/sbweb/fisica/cinematica/regresion/regresion.htm

[Consulta: 2012, Octubre 10].

Cruz, A. (2009). Pruebas de

Hipótesis para una muestra. (Documento en línea). Disponible: http://www.monografias.com/trabajos30/prueba-de-hipotesis/prueba-de-hipotesis.shtml

[Consulta: 2012, Octubre 10].

Monge, J., y Pérez, A., (2010) Estadística

No Paramétrica. (Documento en línea). Disponible: http://www.uoc.edu/in3/emath/docs/Chi_cuadrado.pdf

[Consulta: 2012, Octubre 10].

Multimania (sf). La prueba más

universal para la comparación de dos tratamientos. (Documento en línea).

Disponible: http://usuarios.multimania.es/guillemat/t_student.htm [Consulta:

2012, Octubre 10].

Rábago, J. y Otros (2007)

Procesamiento estadístico de datos con SPSSS. Universidad Pedagógica

Experimental Libertador. UPEL – IPB. Barquisimeto, estado Lara.

Stad Center. (sf). ESTADISTICA

INFERENCIAL. (Documento en línea). Disponible: http://www.stadcenterecuador.com/contenidos/estadistica-inferencial.html?start=2

[Consulta: 2012, Octubre 10].

Tripod (2012). Introducción

a la inferencia estadística. (Documento en línea). Disponible: http://aathosc.tripod.com/introinfest.htm

[Consulta: 2012, Octubre 10].

UCM. (2010). Población y Muestra. (Documento en línea).

Disponible: www.ucm.es/info/genetica/Estadistica/estadistica_basica%202.htm [Consulta:

2012, Octubre 10].

Universidad de Valencia. (2011).

SPSS. (Documento en línea). Disponible: http://www.uv.es/innovamide/spss/SPSS/SPSS_0701b.pdf

[Consulta: 2012, Octubre 10].

.jpg)

.jpg)

.jpg)